Dans un article paru hier dans la revue Nature, l’Intelligence Artificielle était encore à l’honneur. Les auteurs ont exposé le concept d’IA coopérative en y vantant ses mérites et ses limites.

J’avoue que cette lecture m’a laissé un peu perplexe. J’ai eu l’impression qu’il s’agissait d’une nouvelle approche, avant de me replonger dans mes travaux.

Détaillons le propos et voyons ce qui est novateur.

Je cite les auteurs Alan Dafoe, Yoram Bachrach, Gillian Hadfield, Eric Horvitz, Kate Larson & Thore Graepel :

« Pour aider l’humanité à résoudre les problèmes fondamentaux de coopération, les scientifiques doivent repenser l’intelligence artificielle comme profondément sociale. »

Autant le dire tout de suite, rien que cette phrase a dû faire bondir de nombreux chercheurs, notamment en Systèmes Multi-Agents. En effet, le concept d’agent social existe maintenant depuis longtemps. Je me rappelle, par exemple, de la classification d’agents d’Olivier Boissier publiée en 2001 qui en faisait déjà état.

Pour appuyer ce « nouveau » besoin, les auteurs évoquent les véhicules autonomes qui interagissent avec leur environnement naturel mais encore peu ou pas avec d’autres entités équivalentes ou des piétons. « L’agent intelligent, comme un enfant, doit d’abord comprendre son environnement et apprendre à interagir avec lui. » Selon les auteurs, il semble que les chercheurs ne se soient pas encore attaqués à ces problèmes de coopération…

Avant de développer leur propos, ils ajoutent que l’Intelligence Artificielle nécessite des aptitudes sociales et d’intelligence coopérative pour s’intégrer dans nos sociétés et que nous devons créer une science de l’IA coopérative (jeux coopératifs, travaux sur des espaces sociaux complexes, etc).

Je suis bien d’accord sur le constat général mais il me semble que l’on enfonce des portes ouvertes et dire que ce champ d’investigation est nouveau ou presque, est juste une énorme erreur.

Les auteurs ne sont pourtant pas des novices. On y trouve des chercheurs, des professeurs, des ingénieurs d’entreprises comme DeepMind ou Microsoft. Mais continuons la lecture.

De l’autonomie à la coopération

Le constat est que les programmes d’IA fonctionnent généralement en autonomie. Cependant, dans le cas des véhicules intelligents, ils doivent interagir avec l’environnement mais aussi les autres voitures, des piétons, des cyclistes, etc. Et ils doivent donc se coordonner. L’intelligence coopérative n’est donc pas vue comme une alternative à l’intelligence autonome mais elle la complète pour aller plus loin.

Les auteurs listent 4 éléments clés de ce type d’intelligence :

- La compréhension de l’environnement, des actions des autres acteurs, etc ;

- La communication ou habilité à expliciter et échanger de l’information ;

- L’engagement ;

- Les normes et les institutions : infrastructures sociales pour renforcer la compréhension, la communication et l’engagement.

Oui, tout ceci est primordial pour des échanges coopératifs ou collaboratifs. Mais encore une fois, il n’y a rien de nouveau. Les travaux sur ces aspects sont anciens.

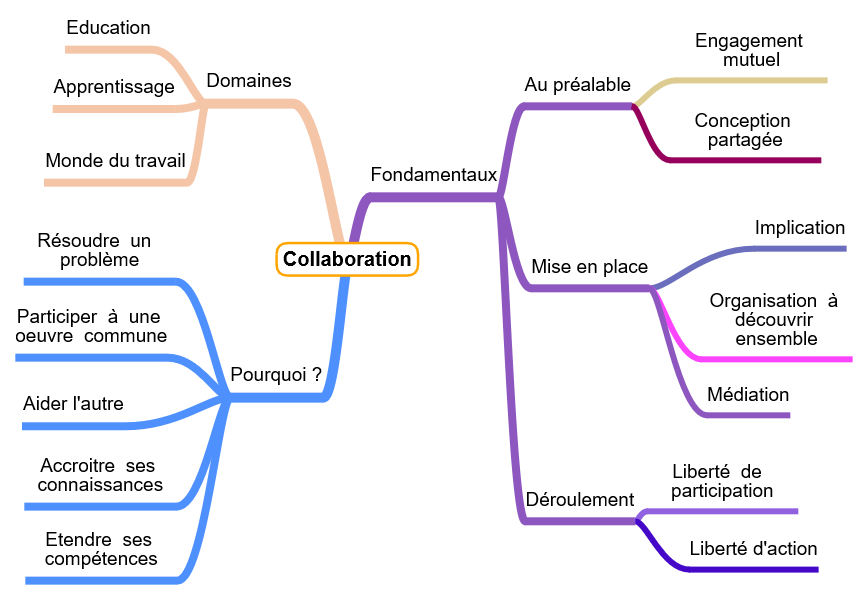

J’avais basé mes recherches sur la coopération et la collaboration sur des approches multiples comme dans le monde de l’éducation et du travail.

Au niveau conceptuel, une collaboration implique :

- Conscience de faire partie d’un ensemble travaillant autour d’un objectif partagé ;

- Motivation pour essayer d’obtenir un consensus dans la résolution de problèmes ;

- Auto-synchronisation pour décider en tant qu’individu lorsqu’un événement survient ;

- Participation à une collaboration en espérant que d’autres participent également ;

- Médiation : négocier et collaborer ensemble pour trouver un compromis ;

- Réciprocité : partager et espérer un retour ;

- Réflexion : penser et considérer les alternatives :

- Engagement de manière proactive. Être un acteur de la collaboration.

Le schéma ci-dessous synthétise quelques notions.

Types de coopération

Les auteurs en listent 3 :

- entre plusieurs IA ;

- entre un être humain et une IA ;

- IA pour aider des coopérations entre humains.

Dans le cas d’une coopération entre plusieurs IA, les problèmes soulevés sont liés à la résolution des conflits. La communication est réellement un facteur clé pour les échanges d’information, de plans, d’objectifs, etc.

Il est fait mention de la notion d’intention qui me paraît crucial pour la mise en œuvre de comportements coopératifs et collaboratifs.

On y parle aussi d’un vocabulaire commun pour communiquer, créer et exécuter des plans élaborés conjointement.

Pour les coopérations entre IA et humains, les auteurs citent les cobots (collaborative robots) dans le monde industriel, les care robots ou les assistants vocaux. Là encore, il paraît évident que toutes les IA devant interagir avec les êtres humains devront apprendre les règles et autres normes sociales.

Les programmes d’IA pourront enfin aider les humains dans leurs propres interactions coopératives en facilitant le dialogue.

La conclusion des auteurs

Pour réussir, l’IA coopérative doit connecter les sciences sociales et comportementales en incluant la psychologie, l’histoire, la sociologie, l’anthropologie, les sciences politiques et économiques, etc.

Et je suis totalement en phase. Il est nécessaire de s’ouvrir à d’autres domaines scientifiques pour en faire la synthèse et améliorer les systèmes. Mais c’est ce que nous faisons déjà !

L’intention des auteurs semble un peu plus évidente à la fin de l’article car ils font la promotion de la Cooperative AI Foundation pour « supporter ce domaine naissant » !

Je suis vraiment gêné par ce genre d’initiative et je ne sais pas trop quoi en penser. Ça donne l’impression de « faire du neuf avec du vieux ». Si vous avez quelques idées sur la question, n’hésitez pas à me contacter.

Systèmes Multi-Agents, Coopération et Collaboration

Nous retrouvons toutes les problématiques évoquées plus haut dans le monde SMA comme :

- Intention : prise de conscience d’un besoin ;

- Interaction : prise de contact avec un autre agent pouvant aider ;

- Communication : moyens pour échanger les informations ;

- Coordination : synchronisation des actions pour accomplir des tâches communes ;

- Négociation : médiation pour trouver un compromis ;

- Organisation : structure et mécanisme des relations entre agents.

Il est impossible de tout détailler ici car chacun de ces items est un champ d’investigation à part entière.

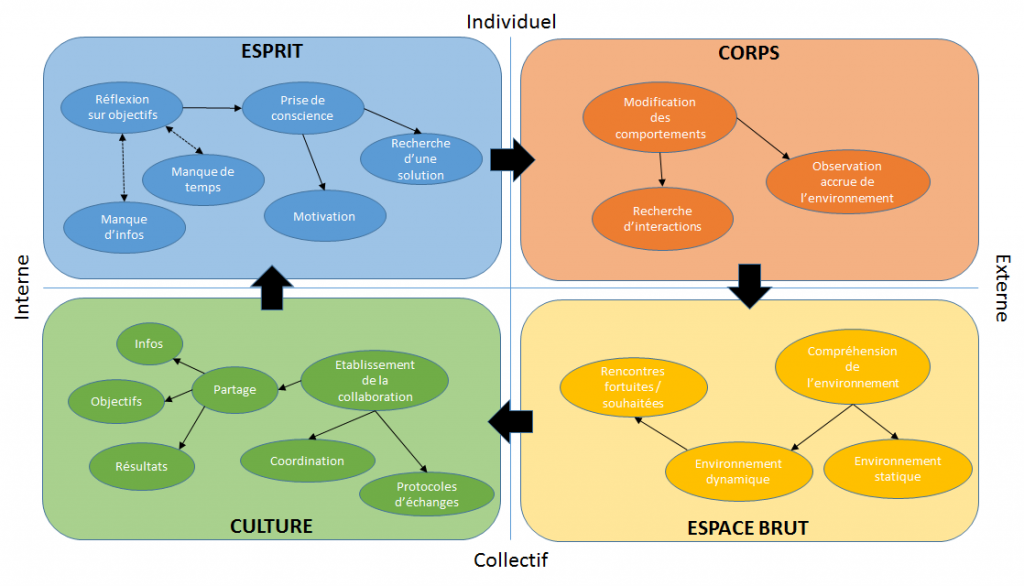

J’avais proposé une réflexion sur la notion de collaboration en utilisant les quadrants de John Tranier :

En invoquant ce découpage, je cherchais à montrer l’agent collaboratif comme une entité intelligente, pensante et sociale. Par la suite, j’ai développé le concept avec une mise en application pour les véhicules intelligents, connectés et communicants (!) mais c’est une autre histoire…

Ma conclusion

Même si je suis réellement partagé sur les motivations sous-jacentes des auteurs et leur manière d’amener le sujet, je suis néanmoins totalement d’accord sur le fond.

Plus nous créons des programmes intelligents, plus il est primordial de pouvoir interagir, communiquer et coopérer avec eux. Il est donc nécessaire de leur inculquer des règles de conduite, des comportements sociaux évolués voire complexes.

Les SMA explorent ces aspects depuis de nombreuses années et je suis heureux de les mentionner ici car c’est un domaine scientifique riche et varié.