L’Intelligence Artificielle est un domaine scientifique tentaculaire. Il est difficile d’appréhender globalement le sujet sans catégoriser.

Les objectifs de cet article sont donc de donner quelques éléments historiques et chronologiques afin de positionner le domaine dans le temps.

Un deuxième article à suivre aura pour objectifs de présenter les grands concepts de l’I.A. de manière organisée. Enfin, un troisième article proposera quelques perspectives potentielles et listera quelques nouvelles considérations liées à ce sujet.

Remarques : Une chronologie plus détaillée sera proposée ultérieurement. Les cas d’application ne sont pas traités. Ils feront l’objet d’un prochain article.

Eléments historiques

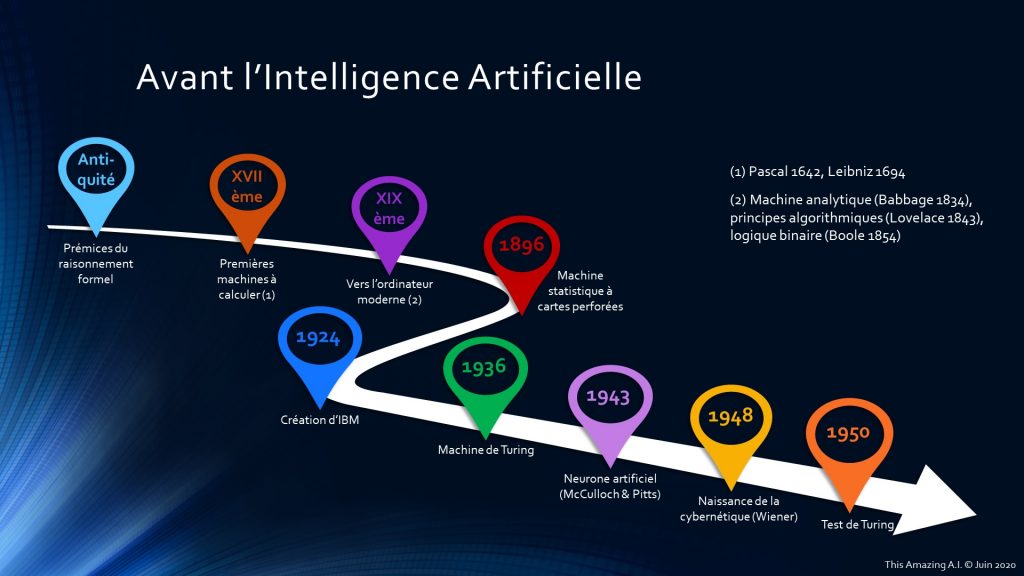

Depuis l’antiquité, de nombreux philosophes et penseurs tentent de définir ce qu’est l’être humain et comment il raisonne. Les prémices du raisonnement formel datent de cette époque. Les civilisations grecques, romaines et arabes ont compté de nombreux scientifiques s’intéressant à ce sujet.

Même si le Moyen-Age n’est pas en reste sur le plan scientifique et philosophique (malgré les préjugés de certains acteurs de la Renaissance), il faut attendre le XVIIème siècle pour voir apparaître les premières machines à calculer (Pascal et Leibniz).

Le XIXème siècle a permis de nombreuses avancées notamment grâce à la machine analytique de Charles Babbage en 1834, les travaux d’Ada Lovelace en 1843 sur le principe de l’algorithme ou encore « Les Lois de la Pensée » de George Boole en 1854 décrivant le logique binaire.

La fin du siècle aura été marquée par l’invention de la machine statistique à cartes perforées de Herman Hollerich en réponse à un appel d’offre du bureau américain du recensement. Il fonde la société Tabuling Machine Company en 1896 qui deviendra International Business Machines (IBM) en 1924.

Après 1936 et les travaux d’Alan Turing sur sa machine (modèle abstrait du fonctionnement des appareils mécaniques de calcul), les événements vont s’accélérer. Le contexte de la seconde guerre mondiale a grandement contribué aux avancées scientifiques et au développement de nombreuses techniques.

En 1943, le chercheur en neurologie Warren McCulloch et le mathématicien Walter Pitts proposent la définition d’un premier neurone artificiel. En 1948, Norbert Wiener invente la cybernétique (du grec kubernetes, pilote) qui permet d’expliquer et de comprendre tous les mécanismes rencontrés avec quelques briques logiques simples (boite noire, entrées / sorties, propagation d’information). Il introduit également la notion de feedback (rétro-action) qui aura des implications dans la plupart des domaines scientifiques.

En 1950, Turing propose son désormais célèbre test pour mettre à l’épreuve une intelligence artificielle sur sa faculté à imiter une conversation humaine (The Imitation Game).

Acte de naissance

Lors du Summer Camp (atelier scientifique pluri-disciplinaire) de Darthmouth pendant l’été 1956, John McCarthy suggère le terme d’intelligence artificielle qui est défini de la manière suivante :

« Chaque aspect de l’apprentissage ou toute autre caractéristique de l’intelligence peut être si précisément décrit qu’une machine peut être conçue pour le simuler. »

Marvin Lee Minsky est également souvent cité comme co-auteur. Selon lui, l’intelligence artificielle doit utiliser des approches multiples, notamment pour la représentation des connaissances, au lieu de se limiter à une seule approche qui serait censée être la meilleure.

Un nouveau domaine scientifique est né !

Chronologie sélective

En 1957, Franck Rosenblatt invente le Perceptron (neurone formel muni d’une règle d’apprentissage qui permet de déterminer les poids synaptiques). Les années qui suivent sont fastes pour le domaine jusqu’à l’article de Marvin Lee Minsky qui vient plomber la recherche et surtout les investissements. Nous assistons à un premier hiver de l’IA. Il va durer près de 10 ans !

Dans les années 80, la recherche reprend grâce aux succès de Hopfield, Rumelhart ou Le Cun dans le domaine des réseaux de neurones. En parallèle, la décennie verra le développement des systèmes experts qui connaîtront un grand succès. Malheureusement, de nouvelles désillusions sur les possibilités de l’IA suspendront les investissements durant quelques années (jusqu’en 1993).

Fin des années 80 et début des années 90, de nouvelles disciplines se développent. Nous pouvons noter les travaux de Brooks sur la robotique et les premiers papiers sur les systèmes multi-agents (IA distribuée).

Un événement viendra marquer l’année 1997. Une intelligence artificielle du nom de Deep Blue de la société IBM bat le champion du monde des échecs de l’époque Garry Kasparov.

Progressivement, la technologie se développe, notamment les premières cartes GPU de la société Nvidia dont les processeurs sont utilisés pour entraîner les réseaux de neurones. AlexNet en 2012 (réseau de neurones à convolution) en remportant le ImageNet Large Scale Visual Recognition Challenge est la preuve magistrale que les réseaux de neurones ont désormais atteint la maturité nécessaire pour envisager le développement de nouveaux algorithmes et de nouvelles solutions informatiques.

Aujourd’hui, le domaine de l’IA connexionniste est en plein essor. Cependant, certains experts commencent à se demander si cette technologie n’a pas atteint son apogée. L’avenir nous le dira !

Vous pouvez retrouver l’intégralité de cette présentation dans la section Infographies.